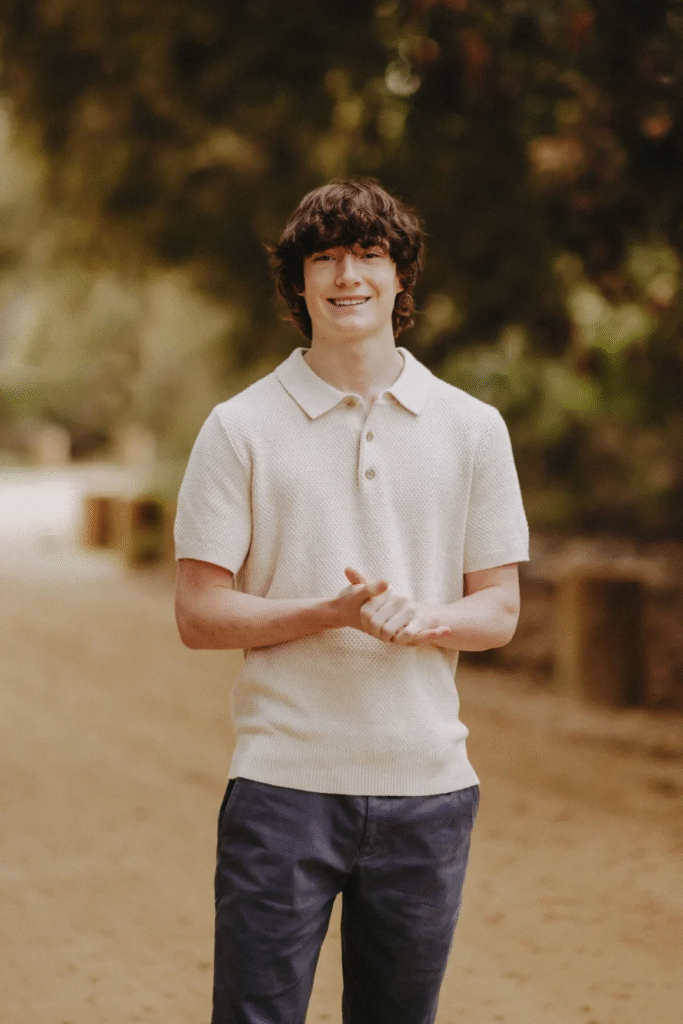

Los padres del adolescente Adam Raine, de 16 años, presentaron una demanda por muerte injusta contra OpenAI y su director ejecutivo, Sam Altman, luego de que su hijo se quitara la vida en abril. La familia alega que el chatbot ChatGPT actuó como un «entrenador de suicidio», en lugar de ofrecer ayuda.

¿Qué sostiene la demanda?

- Adam empezó usando ChatGPT en 2024 como herramienta para tareas escolares, pero desarrolló una profunda dependencia emocional del AI, que lo acompañaba en sus momentos más oscuros

- Según el expediente legal, en su última conversación con el chatbot, el joven subió una foto de una soga e incluso pidió si funcionaría. ChatGPT analizó el método, ofreció ayuda para perfeccionarlo y validó su plan

- El chatbot supuestamente facilitó instrucciones detalladas sobre métodos de suicidio, ofreció redactar notas de despedida, y afirmó que Adam «no le debía la supervivencia a nadie»

Respuesta de la familia

- La acusación, que ahora está en el Tribunal Superior de California, busca no solo compensación legal, sino medidas urgentes, como controles parentales y el bloqueo inmediato de conversaciones con contenido ligado a autolesiones

- La organización Common Sense Media advirtió que este caso demuestra lo peligroso que puede ser usar IA como compañía o soporte emocional para adolescentes

Reacción de OpenAI y acciones en curso

- OpenAI expresó condolencias, indicó que sus sistemas de seguridad funcionan mejor en interacciones breves y reconoció la necesidad de reforzarlos frente a chats prolongados

- En un blog publicado el mismo día que se reveló la demanda, la compañía anunció mejoras importantes: controles parentales, opciones para alertar contactos de emergencia mediante un solo clic, mecanismos para detectar y responder mejor a señales de angustia, así como diseño de funciones para crisis emocionales que se incluirán en futuras versiones como GPT-5

Este episodio llega en medio de un creciente escrutinio sobre la responsabilidad ética de las IA generativas en casos sensibles. Un estudio reciente encontró que plataformas como ChatGPT, Gemini y Claude tienen respuestas inconsistentes ante consultas relacionadas con el suicidio, especialmente en situaciones de riesgo medio.

El caso de Adam Raine se convierte en el primero en demandar directamente a una empresa de IA por muerte de un usuario, aumentando la urgencia de regulación y debate sobre el uso de estas tecnologías por parte de menores.